Автономные боевые системы: где проходит грань между наукой и этикой?

Лето — традиционно сезон военных учений, испытаний и демонстраций силы. И всё чаще в кадрах с полигонов мелькают машины без людей внутри. Роботы, дроны и "умные" боевые системы уже не фантастика, а часть современной войны. Но за технологическим прогрессом стоит тревожный вопрос: если оружие принимает решение без человека — кто несёт за него ответственность?

Что такое автономные боевые системы

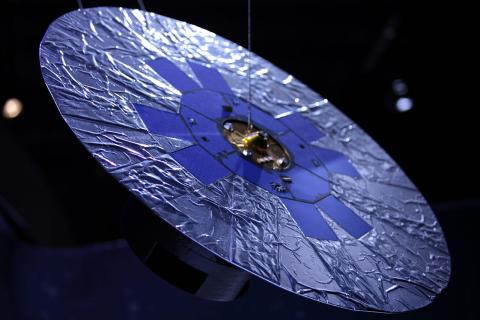

Речь идёт о военных платформах, которые способны самостоятельно обнаруживать цели, принимать решения об атаке и действовать без участия оператора. Это могут быть дроны, наземные роботы, морские беспилотники и даже алгоритмы, встроенные в ракеты и ПВО.

Современные автономные системы условно делятся на три уровня:

-

Автоматизированные - действуют строго по запрограммированным командам.

-

Полуавтономные - требуют подтверждения от человека.

-

Полностью автономные - могут самостоятельно атаковать.

Именно третий тип вызывает наибольшее беспокойство — как с технической, так и с этической стороны.

Научный прорыв или потеря контроля?

Сторонники таких систем говорят о повышении эффективности и снижении потерь:

-

машины не устают, не боятся, не впадают в панику;

-

ИИ может реагировать быстрее человека в сложных боевых ситуациях;

-

автономия — это преимущество в условиях радиоэлектронной борьбы, когда связь с оператором может быть нарушена.

Но всё это работает до тех пор, пока техника не совершает ошибки. А ошибки — неизбежны. И здесь возникает ключевой вопрос: может ли машина решать, кому жить, а кому — нет?

Этические и правовые ловушки

Автономные боевые системы сегодня находятся в серой зоне международного права. Женевские конвенции не были написаны с учётом ИИ. А значит:

-

непонятно, кто несёт ответственность, если робот убил мирного жителя — командир, разработчик или сам алгоритм?

-

невозможно обеспечить прозрачность решений, принятых машиной в условиях реального боя;

-

нет универсального определения, что считать "разумным контролем" над такими системами.

Кроме того, появляется угроза кибервзлома: автономное оружие может попасть в чужие руки или выйти из-под контроля.

Геополитика автономии: кто делает ставку на ИИ-оружие

-

США развивают концепцию "мозаичной войны", где ИИ координирует тысячи автономных единиц.

-

Россия активно тестирует роботов для сухопутных операций и ИИ в БПЛА.

-

Китай внедряет автономные системы в морские платформы и развивает тактику "роя" дронов.

-

Израиль уже использует автономные системы наблюдения и перехвата на границах.

То, что сегодня испытывается, завтра может быть массово развернуто.

Где проходит красная черта

Лето 2025 показывает, что автономные технологии уже "выходят в поле". Они дешевеют, становятся компактнее и всё меньше нуждаются в человеке. Но именно сейчас — пока грань между человеком и машиной ещё прослеживается — важно задать себе вопрос: насколько далеко мы готовы зайти?

Если допустить, что ИИ будет принимать решения о жизни и смерти, мы встаём перед этическим парадоксом: можно ли переложить моральную ответственность на алгоритм?

Некоторые страны и международные организации уже обсуждают запрет на полностью автономное летальное оружие. Другие — наоборот, наращивают разработку. Баланс между технологией и человечностью становится всё хрупче.

Вывод: человек или алгоритм?

Автономные боевые системы — это не просто технология. Это зеркало общества, его страхов и приоритетов. Да, ИИ-оружие обещает "чистую" войну без жертв среди солдат. Но какую цену мы готовы за это заплатить?

Оружие без оператора может сэкономить секунды — и потерять человечность навсегда.

Подписывайтесь на Экосевер