ИИ научился сам связывать зрение и слух — как это меняет будущее технологий

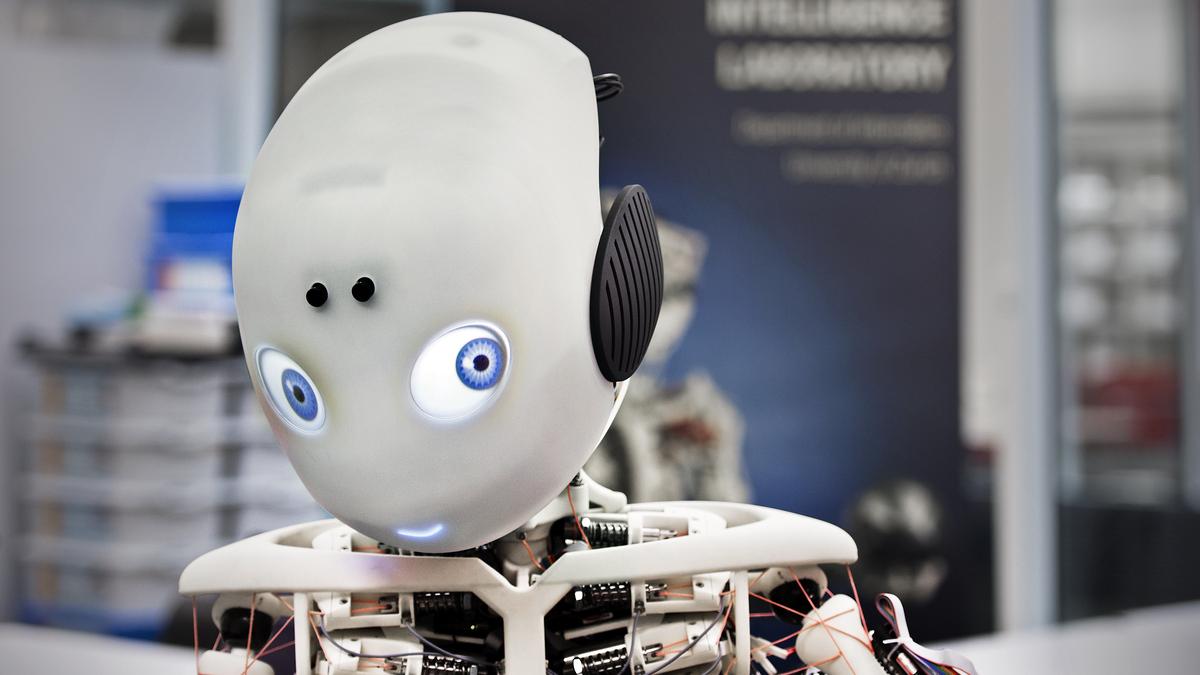

Учёные Массачусетского технологического института (MIT) сделали прорыв в области искусственного интеллекта: они обучили нейросеть связывать зрительные и слуховые сигналы — полностью без участия человека. То, что для человека естественно с младенчества — понимать, что собачий лай исходит от движущейся пасти животного — теперь стало доступно и для машин.

Без аннотаций и лейблов

Ранее такие задачи требовали тонкой настройки и огромных массивов размеченных данных. Однако в новой работе команда MIT представила систему, которая использует так называемое «самосогласование» между изображениями и звуками. Это означает, что ИИ сам учится определять, какие звуки соответствуют каким визуальным элементам — просто анализируя видеоряд и аудио.

Такой подход имитирует естественный процесс обучения ребёнка: слыша звук и видя действие, мозг формирует связи между ними. Новая модель нейросети делает то же самое, но без необходимости в человеке-наставнике.

Что это меняет?

Открытие может кардинально изменить разработку автономных систем: дронов, роботов, ассистентов с ИИ. Ведь чем точнее машина воспринимает реальность, тем адекватнее она на неё реагирует.

К примеру, робот сможет не просто «увидеть», что кто-то хлопает в ладоши, но и «услышать» это — и соотнести звук с жестом. Или автономный автомобиль поймёт, что за углом едет машина, потому что уловил шум двигателя, даже если её ещё не видно.

Кроме того, это открывает возможности для создания более реалистичных виртуальных агентов и персонажей в играх, обучающих системах и даже в цифровых ассистентах.

Будущее мультисенсорного ИИ

Команда MIT подчёркивает, что их метод не только расширяет возможности восприятия, но и делает ИИ более гибким и адаптивным. Без привязки к конкретной разметке или языку система может работать в самых разных условиях и культурах.

Также модель можно применять в ситуациях, где невозможно получить аннотированные данные — например, при анализе дикой природы или видеоархивов.

Это шаг в сторону «по-настоящему умных» машин, способных не просто выполнять команды, но и понимать мир так же, как это делает человек. Или, по крайней мере, пытаться.

Источник: MIT News

Кстати, подобные эксперименты всё чаще совершаются в игровом и кинематографическом ИИ — там зрительно-звуковая сцепка тоже критически важна.

Подписывайтесь на Экосевер