Рассвет сознательных машин: моральный императив искусственного интеллекта

Стремление сделать искусственный интеллект (далее "ИИ") более похожим на человека полностью оправдано. Мы ценим "интеллект" как краеугольный камень нашей эволюции. Эта ценность глубоко укоренилась в каждой человеческой культуре.

Что заставило наш вид выжить, когда были хищники, лучше оснащенные, — так это наша способность учиться, изобретать и адаптироваться. ИИ будет мощным зарядом для человеческого интеллекта и творческого потенциала. Экономические причины для поиска еще более интеллектуальных машин также глубоки.

Хотя искусственный интеллект разрушит многие профессии, такие как производство и розничная торговля, нет другой технологии, которая могла бы обеспечить такой постоянный экономический рост и процветание для будущих поколений. Для науки появление машин, способных обрабатывать огромные объемы данных и открывать новые знания, не могло бы наступить в лучшее время.

Каждая научная дисциплина получает выгоду от ИИ для управления потоком данных. Физики используют его для исследования фундаментальных законов природы, биологи — для поиска новых лекарств для лечения болезней, врачи — для улучшения диагностики и лечения. Преследование дальнейшего развития искусственного интеллекта по культурным, экономическим и научным причинам имеет смысл. Но по мере того, как наши машины становятся более человечными, и по мере того, как все больше приложений начинают внедрять некоторый искусственный интеллект, начинает возникать фундаментальная проблема.

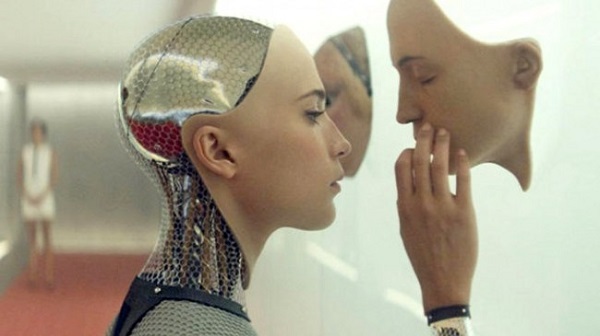

Эмуляция человеческого мозга с искусственными нейронными сетями означает, что компьютеры загадочны и непрозрачны. Это так называемая "проблема черного ящика" ИИ. В мозге и в машине информация распространяется по сети. Когда мы извлекаем номер телефона из памяти, мы не получаем доступа к той части мозга, где номер каким-то образом выгравирован в нашей плоти. Вместо этого каждое число распределено по нескольким синапсам, которые соединяют различные нейроны на разных уровнях организации. Мы на самом деле не "знаем", что мы знаем или каким образом мы это знаем. Только благодаря тому, что мы обладаем сознанием, мы можем ретроспективно рационализировать и, таким образом, "объяснить" нашу интуицию и идеи.

Как показал американский нейробиолог Дэвид Иглман, большая часть того, что нам стало известно, уже произошла в мозге на бессознательном уровне. Для людей это исторически не было проблемой, потому что в наших моральных и правовых системах мы предполагали, что каждый из нас несет личную ответственность за свои мысли и поступки — по крайней мере, когда химический состав нашего мозга находится в пределах социально приемлемых уровней нормального состояния, адекватности". Тем не менее, для неосознанной интеллектуальной машины "проблема черного ящика" предполагает, что, хотя прогнозы и рекомендации, сделанные машиной, могут быть точными и полезными, машина не сможет объяснить свои рассуждения. Представьте себе автомобиль без водителя, принимающий решение о жизни и смерти, разбивающийся и убивающий множество людей. С современными технологиями невозможно расшифровать, почему машина приняла решение, которое она сделала.

"Проблема черного ящика" усугубляется, когда данные, которые машина использует для изучения, имеют внутренние предубеждения, которые могут привести к необъективным выводам или асоциальному поведению. Например, в марте 2016 года "Microsoft" выпустила в "Твиттере" бота с возможностью изучать человеческий язык, анализируя живые твиты. Менее чем за 24 часа он начал распространять расистские и ксенофобские беспорядки. Ученые пробовали различные подходы к решению "проблемы черного ящика". В октябре 2016 года ученые "DeepMind" опубликовали в журнале "Nature" статью о "дифференцируемой нейронной вычислительной машине", в которой нейронная сеть сочетается с обычной внешней памятью.

Разделение процесса обработки и данных — это шаг к созданию этически ответственных интеллектуальных машин. Это делает теоретически возможным закодировать моральные ценности, которые подтверждают или препятствуют результатам "черного ящика" нейронных сетей. Но такого гибридного подхода к разработке более безопасного искусственного интеллекта может быть недостаточно в будущем.

Подписывайтесь на Экосевер